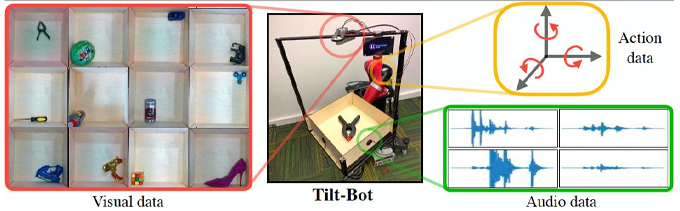

近年来,研究人员开发了越来越多的计算技术,以实现机器人的类人功能。但是,到目前为止开发的大多数技术都只专注于人为地再现视觉和触觉,而忽略了诸如听觉感知之类的其他感觉。近日,卡内基梅隆大学的研究人员设计了一种名为Tilt-Bot的设备来构建动作。通过整合图像和声音,以此来改善机器人的感知能力。

人们很少只使用一种感觉来理解世界,但是机器人通常只能依靠视觉或者通过触摸来感知。

为了进行研究,研究人员创建了一个大型数据集,同时记录了60个常见物体(例如玩具块,手动工具,鞋子,苹果和网球)的视频和音频,当它们在托盘上滑动或滚动并撞向其侧面时。此后,他们发布了该数据集,对15,000个交互进行了分类,以供其他研究人员使用。

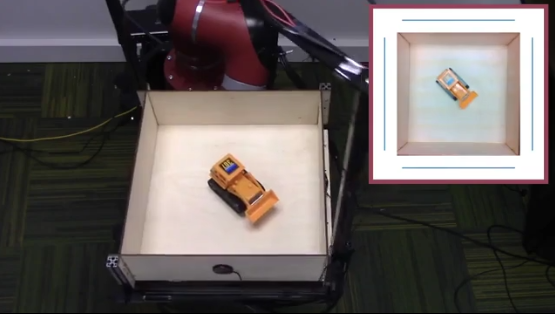

点击查看视频

该团队使用一种称为Tilt-Bot的实验设备(与Sawyer机器人的手臂相连的方形托盘)捕获了这些互动。这是建立大型数据集的一种有效方式 ; 他们可以在托盘中放置一个物体,并让Sawyer花几个小时沿随机方向以不同的倾斜度移动托盘,因为相机和麦克风记录了每个动作。

他们还使用Sawyer将物体推入表面,从而在托盘之外收集了一些数据。尽管此数据集的规模是空前的,但其他研究人员还研究了智能主体如何从声音中收集信息。例如,机器人学助理教授奥利弗·克鲁默(Oliver Kroemer)领导了一项研究,即使用声音通过摇晃容器或估计勺子中的物料流量来估算大米或面食等颗粒物料的量。

他们发现,例如,机器人可以利用从一组物体的声音中学到的知识来预测以前看不见的物体的物理特性。他说:“我认为真正令人兴奋的是,当它失败时,它将在您期望失败的事情上失败。” 例如,机器人无法使用声音来分辨红色块或绿色块之间的差异。“如果它是一个不同类型的物体,如一个方块与一个杯子,这就相对容易的多。”

这项工作只是将声音整体集成到机器人技术中的第一步。在未来的工作中,我们将会看到更多声音和动作的更实际的应用。